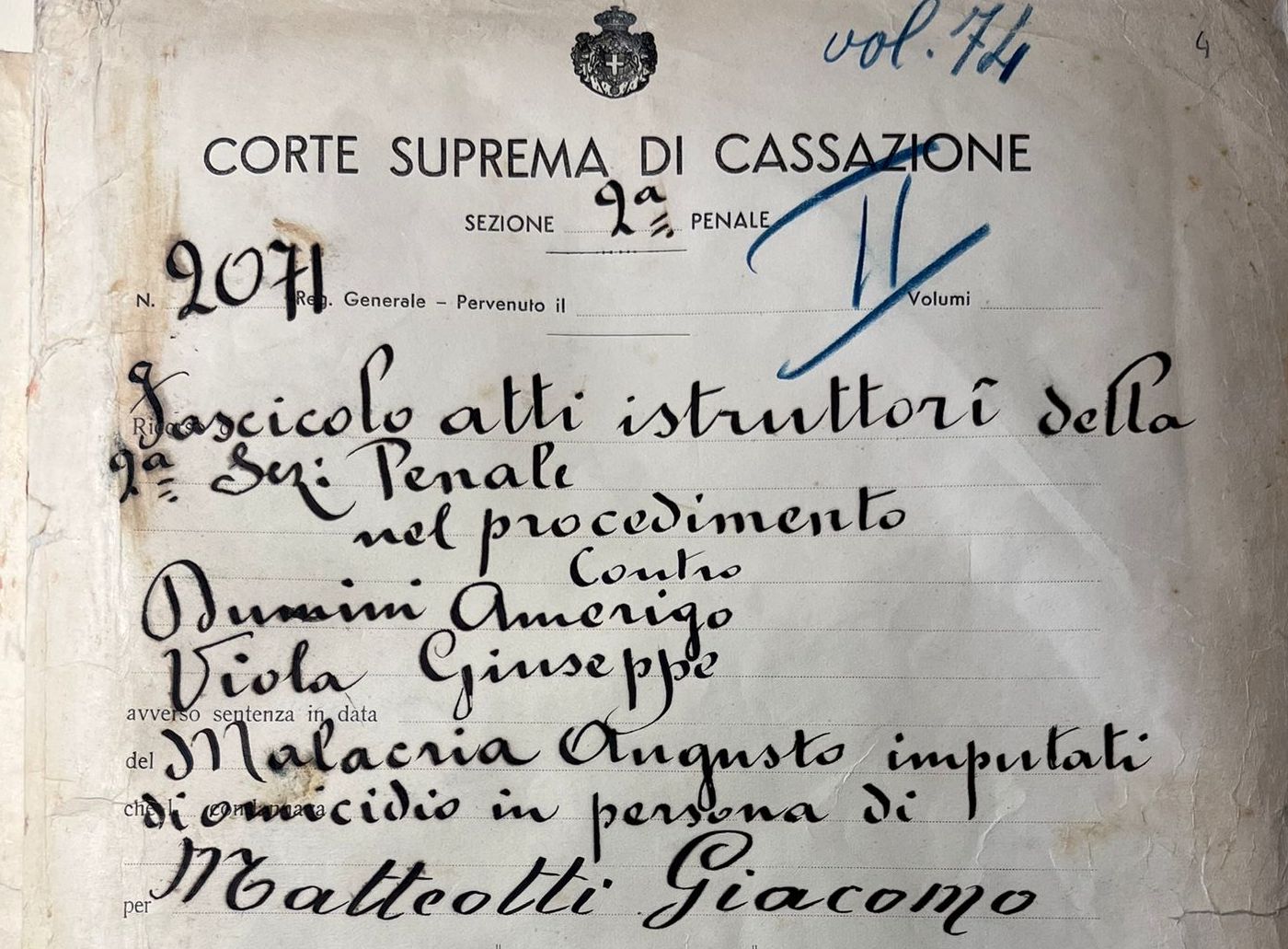

1. Quell’ingenuo ottimista di George Orwell

L’informatica fa parte della vita di tutti da così tanto tempo che ormai solo i più vecchi ricordano il mondo com’era prima, quando per comunicare con persone distanti da noi scrivevamo su sottili strati di alberi macerati chiamati carta e per il resto del tempo eravamo in contatto con pochi altri individui del nostro gruppo, radicati com’eravamo nello specifico fazzoletto del pianeta in cui avevamo avuto la ventura di nascere.

Oggi siamo tutti completamente assuefatti ad un mondo iperconnesso e in cui un unico grande soggetto informatico gestisce ogni istante della nostra vita.

Negli ultimi anni questo stato di cose è tuttavia impercettibilmente cambiato, con l’avvento di quella che convenzionalmente chiamiamo “intelligenza artificiale”.

Di che si tratta?

Nonostante il nome sembri suggerire il contrario, i computer non sono diventati intelligenti, almeno non in senso “umano”.

Però (novità assoluta) ci “parlano”: possiamo rivolgere loro domande del tipo più svariato e in tempo reale ottenere risposte inequivocabilmente generate dalla domanda e non preesistenti.

Questo ci dà l’impressione di dialogare con la macchina e, in definitiva, di avere di fronte un essere senziente.

In realtà non è così. La “logica” dei sistemi informatici di ultima generazione è comunque legata a criteri computazionali e matematici, sicché l’I.A. a cui rivolgiamo la domanda non risponde ragionando, ma selezionando in un tempo velocissimo da una quantità strabiliante di informazioni l’output statisticamente più ricorrente.

In altri termini, i sistemi di I.A. differiscono da quelli tradizionali essenzialmente perché: 1. attingono a una mole infinita di dati grazie alla interconnessione dei server ormai generalizzata; 2 “imparano” dalle precedenti interazioni in modo indipendente dall’intervento umano (c.d. sistemi esperti); 3 simulano il linguaggio umano.

Non sono dunque sistemi intelligenti. Ma sono estremamente pericolosi, perché manipolabili e per di più in modo non visibile, in quanto danno la falsa impressione di fornire risposte “spontanee” e ragionate ad un input da noi fornito, mentre gli output sono condizionati o condizionabili da una molteplicità di fattori che non controlliamo e di cui in definitiva non sappiamo nulla.

Inoltre, le risposte fornite sono completamente prive di “sentimento”, anche se il linguaggio informatico è arrivato ad un livello tale di sofisticazione da simulare una sorta di empatia con l’interlocutore umano.

Questa sensazione fallace aumenta il grado di pericolosità delle interazioni con la macchina e rende anche noi, oltre all’I.A., facilmente manipolabili.

E se tutto questo non bastasse a rendere la situazione abbastanza “orwelliana”, aggiungiamo che attualmente i “rubinetti” da cui i sistemi attingono le informazioni sono in mano ad uno sparuto gruppo di individui, che detengono dunque un pericoloso ed inedito oligopolio planetario dell’unica vera ricchezza oggi spendibile: i dati.

Nessuno di questi nuovi padroni del mondo è italiano, né europeo.

2. Il legislatore europeo chiude le stalle. L’esercizio della giurisdizione diventa attività “ad alto rischio”

Con colpevole ritardo il legislatore UE ha emanato nel 2024 un regolamento per disciplinare l’uso dei sistemi di intelligenza artificiale in tutti i settori, dall’economia al mondo del lavoro, dal settore sanitario a quello della giustizia.

L’intento, lodevole, è quello di garantire che l’Europa resti un luogo “antropocentrico”, dove l’uomo sia ancora al comando della macchina e residui uno spazio di azione per i giudizi di valore, frontiera del tutto sconosciuta – come si è detto – ai nostri “amici” cibernetici.

Il risultato desta qualche perplessità, poiché il testo partorito consta di ben 171 pagine infarcite di norme e definizioni bulimiche e a tratti di difficile comprensione.

Basta leggere la definizione di “sistema di intelligenza artificiale” enunciata all’articolo 3 per comprendere come sia impervia la via scelta per frenare questo treno in corsa o almeno costringerlo in binari di legalità e “umanità”.

Secondo il regolamento UE un sistema di I.A. è “un sistema automatizzato progettato per funzionare con livelli di autonomia variabili e che può presentare adattabilità dopo la diffusione e che, per obiettivi espliciti o impliciti, deduce dall’input che riceve come generare output quali previsioni, contenuti, raccomandazioni o decisioni che possono influenzare ambienti fisici o virtuali”.

Una definizione, a mio avviso, talmente generica da essere di fatto inutilizzabile.

Tanto premesso, il regolamento UE classifica, come noto, le attività umane gestibili mediante sistemi di intelligenza artificiale a seconda del “rischio” che l’uso dell’AI comporta per l’affidabilità del sistema e per la collettività.

L’esercizio della giurisdizione è considerato “ad alto rischio”, soprattutto in considerazione della presenza di dati sensibili che impongono un totale isolamento dei sistemi di intelligenza artificiale utilizzati nel nostro settore.

Come si è detto, si tratta infatti di sistemi basati sull’auto-apprendimento, il che implica che qualsiasi dato contenuto nella stringa di ricerca viene immagazzinato ed entra a far parte della miriade di informazioni in possesso del nostro interlocutore meccanico e sarà utilizzato per le successive ricerche di chiunque, per sempre, per consentire una risposta il più possibile soddisfacente.

Tutto è scritto in modo indelebile ed è potenzialmente visibile a tutti, fino alla fine dei tempi.

Accanto a questo primo, allarmante rischio, comune a tutte le attività umane che presentano carattere di riservatezza ve ne sono altri, specifici del lavoro del giudice, destinato a mutare nel profondo per effetto dell’irrompere delle nuove potenzialità offerte dall’informatica.

Siamo infatti di fronte a scenari del tutto nuovi che mettono a rischio i fondamenti costituzionali dell’esercizio della giurisdizione e impongono una profonda rivisitazione del processo e del ruolo del giudice e delle parti processuali.

3. La legge 132 del 2025. Un nuovo banco di prova per l’articolo 101, 2° comma della Costituzione

In attuazione del regolamento UE sommariamente esaminato nel paragrafo precedente, è stata emanata nel nostro paese la legge numero 132 del 2025, che per la prima volta disciplina in maniera organica l’utilizzo in diversi settori dei sistemi di intelligenza artificiale.

L’articolo 15 è dedicato all’esercizio della giurisdizione.

Al secondo comma si prevede che “il Ministro della Giustizia disciplina gli impieghi dei sistemi di intelligenza artificiale per l’organizzazione dei servizi relativi alla giustizia, per la semplificazione del lavoro giudiziario e per le attività amministrative accessorie”.

La norma risponde alla fisiologica attribuzione al Ministero dei servizi inerenti la Giustizia, sancita da previsione costituzionale (art. 110 Cost.).

Ma sembra trascurare le peculiarità del nuovo “servizio”.

Come si è detto, non si tratta più di un mero supporto informatico all’attività del magistrato come finora accadeva, ma di un sistema manipolabile in modo potenzialmente non visibile ed in grado di condizionare l’in se dell’esercizio della giurisdizione.

Attraverso la configurazione del sistema di intelligenza artificiale fornito ai magistrati è infatti possibile manipolarne le decisioni, in modo talmente sottile da lasciare nel giudice la convinzione di essere giunto ad una conclusione sul thema decidendum senza alcuna influenza esterna, come si dirà di qui a breve.

Non si possono dunque non condividere le preoccupazioni espresse dal CSM, che ha immediatamente emanato un atto per auspicare un coinvolgimento dell’organo di autogoverno della magistratura nella predisposizione dei sistemi in esame.

I timori aumentano se si esamina il terzo comma dell’articolo 15, che disciplina la sperimentazione e l’impiego dei sistemi di I.A. fino alla completa attuazione del regolamento UE, prevista tra circa un anno: “fino alla completa attuazione del regolamento UE 2024/1689 la sperimentazione e l’impiego dei sistemi di intelligenza artificiale negli uffici giudiziari sono autorizzati dal Ministero della Giustizia, sentite le autorità nazionali di cui all’articolo 20”.

Quali sono queste autorità nazionali? L’Agenzia per l’Italia digitale (AGID), l’Agenzia per la cybersicurezza nazionale (ACN), la Banca d’Italia, la Consob e l’IVASS come agenzie di vigilanza del mercato.

In altri termini, il legislatore si è preoccupato (giustamente) delle possibili incidenze dell’impiego dei sistemi di I.A. nell’esercizio dell’attività giurisdizionale nei campi della cybersicurezza, del sistema creditizio e assicurativo, della finanza, del mercato…. riservando a sé in via esclusiva il controllo della parte strettamente giuridica, senza coinvolgere i protagonisti dell’esercizio della giurisdizione, cioè chi dovrà in concreto utilizzare i sistemi informatici.

Se si legge questa norma in combinato con l’articolo 24 della legge in esame, che prevede deleghe al Governo per l’attuazione dei sistemi di I.A. in settori delicatissimi come le attività di polizia e la fase delle indagini preliminari, ne deriva un quadro non tranquillizzante, con una possibile nuova fonte di frizione tra potere esecutivo (e legislativo) e giudiziario in una fase particolarmente delicata da questo punto di vista.

Si esamineranno nei paragrafi seguenti in dettaglio i fattori che possono mettere a rischio l’esercizio indipendente della giurisdizione e il relativo disposto costituzionale (“I giudici sono soggetti soltanto alle legge”) mediante l’utilizzo di sistemi di intelligenza artificiale.

4. I fattori di rischio per un esercizio indipendente della giurisdizione: le attività di ricerca e le banche dati gestite da sistemi di intelligenza artificiale

L’utilizzo di sistemi di intelligenza artificiale nelle banche dati della giurisprudenza è destinato ad avere un impatto enorme: è intuibile quali vantaggi potrebbe apportare al lavoro quotidiano di ciascun magistrato la possibilità di consultare in tempo reale tutti i precedenti di legittimità e di merito emessi da qualsiasi tribunale italiano su una determinata materia.

Si avrebbe un quadro completo e preciso di come ciascuna questione su cui il giudice è chiamato a decidere sia stata affrontata e risolta migliaia di volte prima di lui.

L’enorme mole di dati a disposizione, per essere fruibile, abbisogna però di criteri di selezione del “materiale più rilevante”.

E questa è un’operazione che i sistemi di intelligenza artificiale sono perfettamente in grado di svolgere, fornendo al giudice un aiuto prezioso.

Purché si dia loro un input adeguato.

In questo dettaglio si nasconde la possibile insidia: chi sceglierà quali sono i dati rilevanti?

Cosa accadrà, ad esempio, se il sistema sarà configurato per scartare i precedenti che si discostano dall’indirizzo dominante della Corte di Cassazione? O – in un futuro distopico – del Governo?

E soprattutto, chi se ne accorgerà, non essendo i criteri di selezione degli input accessibili agli utenti, cioè ai magistrati che consultano le banche dati per scrivere i loro provvedimenti (ma anche agli avvocati che ne vagliano l’attendibilità per le loro eventuali impugnazioni)?

È evidente dunque che la configurazione dei sistemi in esame non può essere considerata un “servizio” riservato al Ministro della Giustizia ma impone il coinvolgimento diretto degli esponenti del mondo della giurisdizione, per una tenuta del principio costituzionale dell’articolo 101 Cost più volte menzionato.

5. Il cuore del problema: la decisione

Come detto in precedenza, i sistemi di intelligenza artificiale possono avere influenza diretta anche sul cuore dell’attività giurisdizionale: la decisione demandata al giudice all’esito del processo.

Il già menzionato articolo 15 della legge 132 del 2025 stabilisce il limite insuperabile: «Nei casi di impiego dei sistemi di intelligenza artificiale nell’attività giudiziaria è sempre riservata al magistrato ogni decisione sull’interpretazione e sull’applicazione della legge, sulla valutazione dei fatti e delle prove e sull’adozione dei provvedimenti.”.

Prima che fosse troppo tardi, il legislatore ha sentito dunque l’esigenza – per la prima volta nella storia del diritto – di emanare una norma per prescrivere che la giurisdizione deve rimanere, letteralmente, “umana”.

Si tratta di un principio su cui non è possibile non concordare, essendo di tutta evidenza che il cuore dell’attività giurisdizionale non è riconducibile ad un algoritmo, a meno di non ridurre lo ius dicere alla semplice applicazione meccanica di una norma al caso concreto.

Purtroppo, la declinazione pratica di questo principio potrebbe andare incontro a qualche insidia e porre di fronte la comunità dei giuristi a problemi inediti e di non facile soluzione.

È ciò che potrebbe avvenire in tutti i casi in cui la decisione, pur restando formalmente in capo al magistrato, sarà fortemente condizionata dai sistemi informatici di cui, in misura sempre maggiore, il decidente non sarà più in grado di fare a meno.

Ad esempio, il sistema di intelligenza artificiale in uso ai magistrati potrebbe indicare, sulla base di un algoritmo, la probabilità della colpevolezza dell’imputato sulla base di un esame statistico di precedenti simili.

Lo stesso magistrato potrebbe poi essere tentato dalla possibilità di avvalersi delle nuove capacità informatiche messe a disposizione per abdicare di fatto alla propria funzione delegandola alla macchina.

Un esempio pratico può chiarire questo timore togliendolo dalle secche di un discorso astratto.

È noto che, per giurisprudenza costante, le dichiarazioni accusatorie di un collaboratore di giustizia non sono ritenute sufficienti, in assenza di riscontri estrinseci, per fondare una decisione di condanna per il reato di partecipazione ad un’associazione per delinquere di stampo mafioso.

Tra i riscontri estrinseci, viene ritenuto valido anche il compendio probatorio costituito dalle dichiarazioni di un altro collaboratore di giustizia.

Una stringa di ricerca che demandasse al sistema di intelligenza artificiale di esaminare il fascicolo, selezionare i nominativi degli imputati accusati da due collaboratori di giustizia e scrivere in automatico il dispositivo di condanna rispetterebbe il disposto dell’articolo 15 della legge 132 del 2025?

E se il comando dato al nostro “assistente informatico” fosse solo di selezionare i nominativi degli imputati accusati da due collaboratori di giustizia, lasciando alla parte umana il compito di redigere il dispositivo?

La risposta ad entrambi i quesiti appare intuitiva: la decisione rimarrà “umana” e dunque legittima nella misura in cui il giudice non si limiterà alla trasposizione passiva dei risultati della ricerca ma integrerà la stessa con un ragionamento logico-giuridico trasparente e ricostruibile attraverso la lettura della motivazione.

Il problema è che già da oggi, con il sistema messo a disposizione dal Ministero della Giustizia, è possibile demandare all’I.A… di scrivere la parte della motivazione che “simula” il ragionamento di cui sopra.

Una facile obiezione è che anche senza sistemi informatici i giudici “pigri” potrebbero limitarsi a copiare nelle loro sentenze pezzi interi di motivazione presi da sentenze precedenti.

Ma fino ad oggi occorreva almeno un vaglio critico per compiere questa operazione di “riciclaggio”, perché anche la semplice operazione di copia e incolla presuppone la lettura di ciò che si sta prelevando da fonte esterna e inserendo nel proprio provvedimento. Da oggi, invece, il lavoro sporco può farlo l’assistente meccanico e il giudice può trovarsi la sentenza scritta senza dovere nemmeno fare la fatica di leggerla, né tantomeno di compulsare il fascicolo.

Occorrerà dunque investire, oltre che sulle competenze informatiche dei magistrati, sulla robustezza etica degli stessi, perché ne occorrerà parecchia per resistere alla tentazione di adagiarsi su un testo preconfezionato ed apparentemente ineccepibile, ricordando che ogni singola abdicazione al proprio senso critico anche su un solo provvedimento erode in maniera impercettibile ma irreversibile il capitale di autonomia e indipendenza che a ciascun magistrato è dato in dotazione nell’interesse della collettività.

La Scuola Superiore della Magistratura è di fatto sin da ora investita di un nuovo, delicato compito di formazione sia nella articolazione destinata ai nuovi magistrati (formazione iniziale) che in quella destinata ai magistrati in servizio (formazione permanente).

6. Gli elementi accessori della decisione

Ugualmente insidiosi possono essere gli utilizzi impropri dell’intelligenza artificiale come supporto alle parti accessorie della decisione, quali ad esempio l’applicazione delle circostanze, la dosimetria della pena, gli aumenti di pena per la recidiva e simili.

Apparentemente, si tratta di insidia minore: una volta che il giudice ha preso, in coscienza ed autonomia, la decisione sulla colpevolezza, le parti accessorie – che incidono sul quantum della pena e sul trattamento sanzionatorio – presentano un grado minore di discrezionalità e ben potrebbero, in astratto, essere coadiuvate dallo screening dei precedenti compiuto dai sistemi di intelligenza artificiale.

In merito, vale la pena ricordare il “caso Compas”: un software statunitense ha di recente elaborato una stima della probabilità di recidiva in modo da orientare i giudici per la decisione di concedere o meno la libertà su cauzione.

I criteri utilizzati si sono basati sull’elaborazione dei precedenti, usando come filtri la storia personale dei detenuti, i redditi, i precedenti e simili.

Il risultato elaborato dal giudice cibernetico americano è stato che le probabilità di ricaduta nel crimine aumentano di gran lunga se l’imputato e povero e di colore, con conseguente “suggerimento” di concedere la libertà su cauzione agli imputati bianchi e benestanti….

Ciò a conferma che i sistemi di I.A. non “ragionano” e sono privi di sentimento e buon senso (e non vale osservare che il ragionamento partorito dalla macchina è tristemente assai simile a quello di una percentuale allarmante di giuristi e non).

Per tornare a considerazioni più tecniche, vale la pena ricordare che nel nostro sistema processuale l’articolo 220, secondo comma c.p.p. esclude espressamente il ricorso alla perizia al fine di stabilire «l’esercizio o la professionalità in un reato, la tendenza a commettere un reato, il carattere e la personalità dell’indagato e, in generale, le qualità psicologiche dell’indagato, indipendentemente dalle cause patologiche», ricordandoci che tutto quello che attiene al perimetro dell’articolo 133 del codice penale fa parte integrante della valutazione del giudice e come tale non è delegabile ad “esperti” né al giudizio di un terzo.

7. Un pericoloso connubio: intelligenza artificiale e deriva produttivistica

Gli interventi legislativi sul processo penale (e su quello civile) mostrano negli ultimi anni una forte spinta verso l’aumento della produttività del sistema giustizia.

L’esigenza di affrontare il cronico arretrato che affligge da lungo tempo i nostri Tribunali ha ricevuto un decisivo impulso dal PNRR, che – come noto – ha imposto una drastica riduzione delle pendenze per non costringere lo Stato italiano a restituire il cospicuo finanziamento ricevuto dalla Comunità Europea.

Già la c.d. riforma Cartabia aveva impresso al rito penale una svolta in senso deflazionistico con l’introduzione di una serie di modifiche al processo e sin da allora si è cominciato a parlare di “deriva produttivistica” da parte di chi lamentava una potenziale subordinazione dell’esigenza di approfondimento delle questioni demandate ai giudici a quella, divenuta cogente, di definire comunque il processo.

Da ultimo questa tendenza è divenuta palese con l’emanazione del decreto legge 9 agosto 2025 numero 117, intitolato “misure urgenti in materia di giustizia al fine di consentire il raggiungimento entro il 30 giugno 2026 degli obiettivi del Piano nazionale di ripresa e resilienza previsti nel settore della giustizia”[1], che introduce nel nostro ordinamento due figure di nuovo conio:

- La figura del “giudice cottimista”, addetto allo smaltimento dell’arretrato di uffici diversi dal suo in cambio di vantaggi economici e di carriera;

- La figura del “MOT spalatore”, magistrato vincitore di concorso il cui tirocinio (rectius: una cospicua parte di esso) è stato destinato non alla sua formazione, prodromica alla presa di funzioni, ma ad eliminare l’arretrato accumulato dai colleghi della Corte di Appello.

In entrambi i casi si tratta di innovazioni che privilegiano in modo esplicito la quantità di fascicoli definiti, lasciando sullo sfondo l’approfondimento delle tematiche, lo studio di dottrina e giurisprudenza, la ponderazione a volte necessaria prima di maturare la decisione, la conoscenza che si acquisisce interloquendo nel processo con le parti e così via.

Va da sé che in un clima del genere, che è auspicabile non prepari ad un mutamento irreversibile nel modo di lavorare dei magistrati, l’utilizzo di una scorciatoia potente ed efficacissima quale quella offerta dai sistemi di intelligenza artificiale rischia di suonare come una sirena irresistibile, mandando in soffitta tutti gli auspici espressi nei paragrafi precedenti.

Negli stessi mesi in cui si moltiplicano le pressioni sugli uffici giudiziari perché spingano al massimo i motori in vista della scadenza del PNRR (fissata a giugno 2026), il Ministero offre, inconsapevolmente, lo strumento informatico perfetto per aumentare i giri del motore.

È rimesso al senso di responsabilità di ciascuno, o all’amore per la propria professione, di evitare la tentazione di barattare una maggiore produttività con l’abdicazione della componente umana della decisione, mantenendola nel solco della legittimità sancito dall’articolo 15 della legge 132 del 2025, norma che rischia altrimenti di ridursi ad una petizione di principio.

8. La verticalizzazione della magistratura e l’effetto conformativo generato dall’intelligenza artificiale

Un ultimo fattore di rischio è costituito dalla tendenza, che si può scorgere ultimamente in controluce, ad un impulso alla verticalizzazione della magistratura, cui indirettamente l’uso dei sistemi di I.A. potrebbe dare un contributo.

La tendenza alla verticalizzazione predetta si manifesta sotto molteplici forme.

In primo luogo, va rilevato che le modifiche all’assetto delle Procure con l’accentuazione dei poteri del Procuratore Capo, l’adozione – da parte dei Capi delle Procure più importanti – di linee guida comuni tra diversi uffici e persino di comunicati congiunti hanno dato l’impressione di una costruzione in fieri della magistratura requirente come una piramide, che va a sovrapporsi se non a sostituirsi al tradizionale potere diffuso che è da sempre considerato uno dei baluardi dell’autonomia ed indipendenza dei pubblici ministeri e, per osmosi, dei giudici.

Ma il fenomeno attraversa, con caratteristiche differenti, anche la magistratura giudicante, dove si nota da tempo un appiattimento verso i precedenti della giurisprudenza di legittimità che va al di là della fisiologica funzione di nomofilachia esistente nel nostro ordinamento ed assomiglia molto a quella “pigrizia” di cui è parlato nei precedenti paragrafi.

Ed invero, si nota una crescente tendenza a cercare, nella decisione del singolo caso, il “precedente” della Cassazione da esibire come suggello della motivazione dei provvedimenti decisori quando non, a volte, a sostituire il corpus della decisione stessa.

Non è estranea a questo fenomeno la radicale trasformazione del concorso per accedere alla magistratura, dove si assiste da tempo – anche grazie alle scuole private sorte in gran quantità e al di fuori di ogni controllo – ad una esasperazione del nozionismo a scapito della capacità di ragionamento, con il risultato di favorire l’ingresso di nuove leve abituate per default a ricercare l’avallo delle decisioni assunte in passato e meno incoraggiate alla ricerca di soluzioni personali.

Contestualmente, sembra essersi appannato il senso della funzione propulsiva della giurisprudenza di merito, contestualmente ad una vera e propria demonizzazione della giurisprudenza cosiddetta “creativa” da parte di alcuni commentatori e giuristi.

Il risultato è una diminuzione della consapevolezza del ruolo propulsivo della giurisprudenza di merito ed una implicita subordinazione tra questa e la giurisprudenza di legittimità che va assai al di là della fisiologica osmosi, ciascuno nel suo ruolo, finora esistente tra i gradi di giudizio.

La riforma Nordio, in attesa di conferma (o bocciatura) da parte del referendum, offre precise indicazioni in tal senso, introducendo una preclusione inedita nel nostro ordinamento quando prevede che dell’istituenda Alta Corte disciplinare possano far parte solo magistrati di legittimità; nel concetto che solo un magistrato di Cassazione, indipendentemente da merito, esperienza e persino anzianità di servizio, sia in grado di giudicare gli illeciti disciplinari dei colleghi si intravedono inquietanti segnali di un ritorno ad una magistratura alta e una bassa, divisione che si credeva relegata in soffitta.

In questo contesto è facile immaginare che i sistemi di intelligenza artificiale offrano, ancora una volta, una facile soluzione all’ansia di adeguarsi al precedente di legittimità, presentando una possibile linea interpretativa preconfezionata che può dar luogo ad un pericoloso effetto conformativo.

Non va dimenticato che tra gli obiettivi della riforma Nordio vi è anche l’esplicito aumento di efficacia del sistema disciplinare, ritenuto finora troppo “morbido” e che si nota già da tempo un’aspirazione allo sconfinamento dell’illecito disciplinare al merito delle decisioni.

Non è difficile dunque ipotizzare che in un futuro molto prossimo il discostarsi dalle indicazioni del sistema di intelligenza artificiale possa essere considerato elemento da valutare come eventuale illecito disciplinare, con ulteriore accentuazione del menzionato effetto conformativo e della spinta verticalistica in atto.

Considerando poi che, come si è detto in principio, l’output è di matrice ministeriale e di fatto non controllabile, il campanello di allarme sulla tenuta dell’articolo 101, 2° comma della Costituzione torna a farsi sentire con insistenza.

Anche in questo caso, come visto in precedenza, la magistratura ha in sé gli anticorpi per scongiurare i rischi paventati: occorre un aumento di consapevolezza della rivoluzione informatica in atto e delle sue possibili conseguenze, unito ad un rinnovato senso dell’importanza di esercitare quotidianamente la giurisdizione in modo consapevole e senza scorciatoie preconfezionate.

Tutti strumenti per i quali è indispensabile il ruolo della formazione (e dell’autoformazione) dei magistrati, ciò che chiama ancora una volta in causa il CSM e la Scuola Superiore della Magistratura, organi a ciò deputati (ed in grado, naturalmente a Costituzione invariata, per storia e struttura, di adempiere pienamente a questo compito) e, in tutti i magistrati, il dovere di preservarne indipendenza e autorevolezza.

[1] Mi permetto di rinviare in proposito a C. DE ROBBIO, Vincitori del concorso sbagliato, in questa Rivista, pubblicato il 30 settembre 2025, ove il d.l. 117-25 è dettagliatamente analizzato.